[n8n] self-hosted-ai-starter-kit 인스톨 좌충우돌 이야기

어제까지 회사업무로 바쁘다가 오늘은 금요일이고 해서 이전에 맥북에 받아두었던 ollama를 활용할 방법을 궁리하던중에 인스톨을 하면서 겪은 일을 이렇게 글로 풀어봅니다.

https://github.com/n8n-io/self-hosted-ai-starter-kit?tab=readme-ov-file

GitHub - n8n-io/self-hosted-ai-starter-kit: The Self-hosted AI Starter Kit is an open-source template that quickly sets up a loc

The Self-hosted AI Starter Kit is an open-source template that quickly sets up a local AI environment. Curated by n8n, it provides essential tools for creating secure, self-hosted AI workflows. - n...

github.com

인스톨방법

git clone https://github.com/n8n-io/self-hosted-ai-starter-kit.git

cd self-hosted-ai-starter-kit

docker compose up상단에 있는 링크를 보시면 이 명령러가 있으시겠지만 docker 명령어를 같이 하던중에 패스에 빠져있는 것을 알고 부랴 부랴 설정을 또 추가했답니다.

# ~/.zshrc 또는 ~/.bash_profile 파일에 다음 줄 추가

export PATH="/Applications/Docker.app/Contents/Resources/bin:$PATH"

# 변경사항 적용

source ~/.zshrc # zsh 사용 시

# 또는

source ~/.bash_profile # bash 사용 시명령어를 적용한 이후에는 정상적으로 되구요.

접속방법

브라우저에서 localhost:5678로 접속을 하시면 회원가입 화면이 나오고 그 다음에는 아래와 같은 화면이 나온답니다.

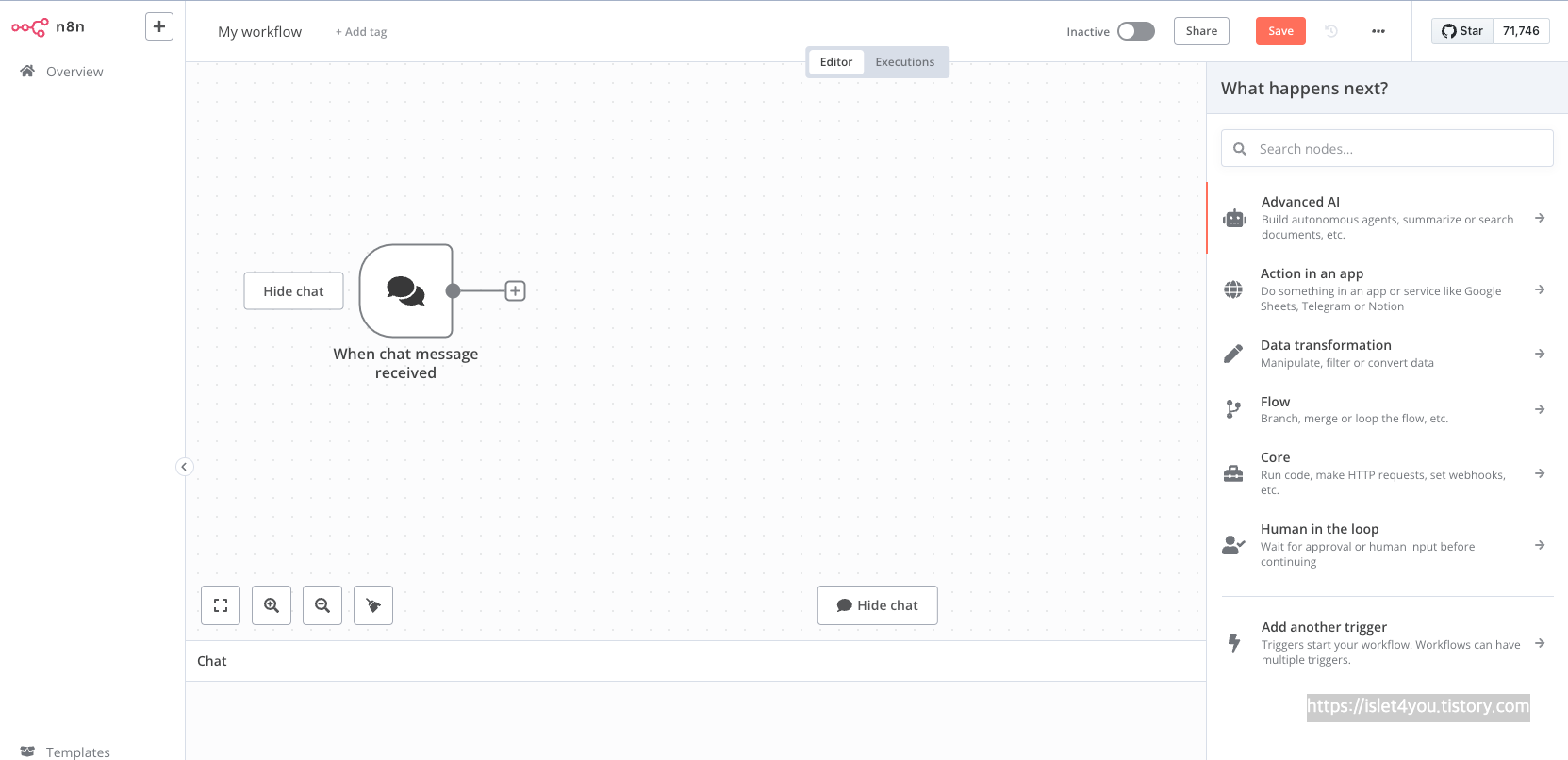

새로운 workflow 를 한번 생성볼께요.

그럼 오른쪽에 workflow를 선택할 수 있습니다.

1. on chat message 를 선택

화면에 추가된 것에서 오른쪽 메뉴에서 Advanced AI 를 선택해보겠습니다.

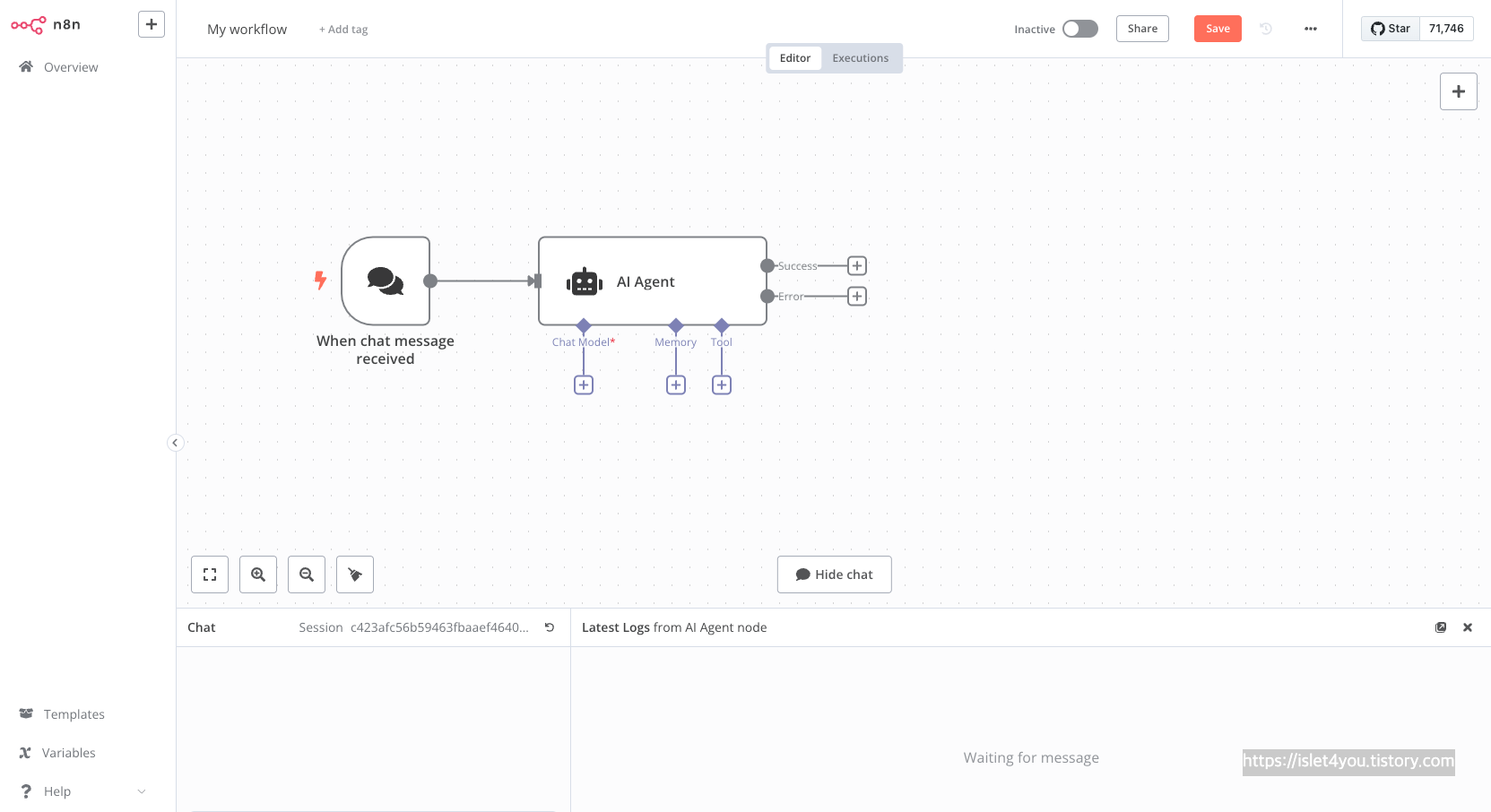

AI Agent 를 추가한 화면은 아래와 같습니다.

2. AI Agent

저는 chat Model 을 제 로컬에 있는 ollama를 한번 셋팅해보겠습니다.

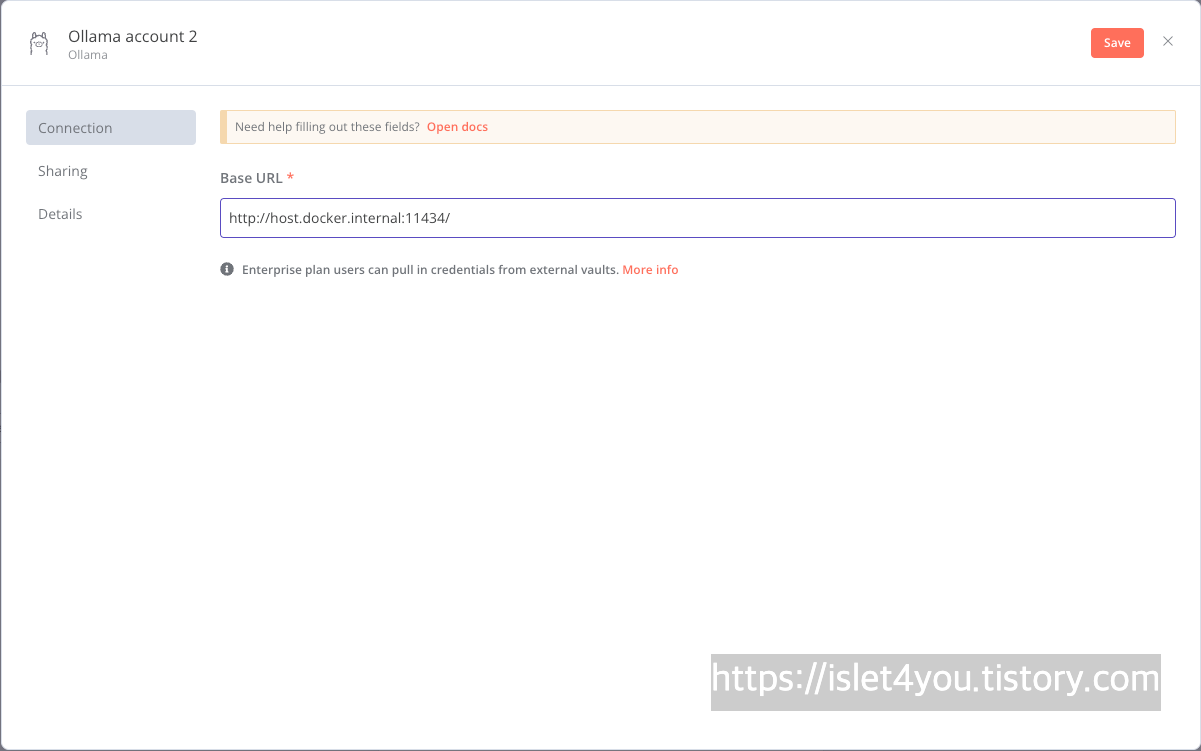

3. Chat model 선택 유의 사항

base url : http://host.docker.internal:11434/ 로 변경하셔야합니다.

로컬의 http://locahost:11434를 사용하시면 안됩니다.

위의 이미지처럼 셋팅을 해주시면 됩니다.

하단에 hello 를 했을때 응답을 한 내용이 한눈에 보이네요. ^^

단점이라면 제가 물은 것에 대해서 한글이 아닌 영문으로 대답을 해주네요 ㅋ

어떻게 접근을 해야할지에 대한 것은 이해를 하게 되었습니다.

좀 더 좋은 걸 찾으면 다시 포스팅 하도록 하겠습니다.

'개발관련 > AI 이야기' 카테고리의 다른 글

| RAG와 CrewAI의 시너지: AI 협업의 새로운 지평 (0) | 2024.07.23 |

|---|---|

| llama 모델 다운받기 (0) | 2024.07.22 |

| [메타의 음악생성 AI] AudioCraft: AI research for audio (0) | 2024.03.08 |

| [Stable Diffusion] Google CoLab에 설치하는 방법 (0) | 2023.05.04 |